Парсеры сайтов

Простое понятие «парсинга» - это извлечение необходимых данных с какого-либо источника информации. Средства для этого процесса и называют парсерами.

Что же обычно парсят?

Представьте, Вы открыли интернет-магазин товаров какого-нибудь бренда, у которого есть свой официальный сайт с тысячами наименований, но доступа к их базе нет и ассортимент в электронном виде они тоже не передают. Заносить все это вручную? На эту работу уйдут десятки человека-часов, что станет просто нерентабельным. Куда проще написать парсер, «натравить» его на этот сайт и за короткое время получить всю базу, и занести её в свой каталог. Все, весь контент готов. Можно парсить не только текстовую информацию, но и изображения и видео.

В свое время мы спарсили весь каталог бытовой техники и выложили его на сайты сервисов по ремонту, чем получили огромный низкочастотный трафик, ищущих ремонт или запчасти для конкретной модели.

Что еще парсят?

Очень простой ответ: все-что угодно. Например, цены. Очень важно знать цены конкурентов, чтобы предлагать свои. Благо, есть много агрегаторов товарных предложений, на которых публикуется сотни других интернет-магазинов. Брать цены для анализа – милое дело. Но, что делать, если товаров опять тысячи, а анализировать надо минимум раз в день?

На помощь опять приходят парсеры. Парсер создается под конкретную площадку и должен постоянно обновляться. Не верьте в существование универсальных программ, которые один раз купил и забыл.

Почему парсеры надо регулярно обновлять?

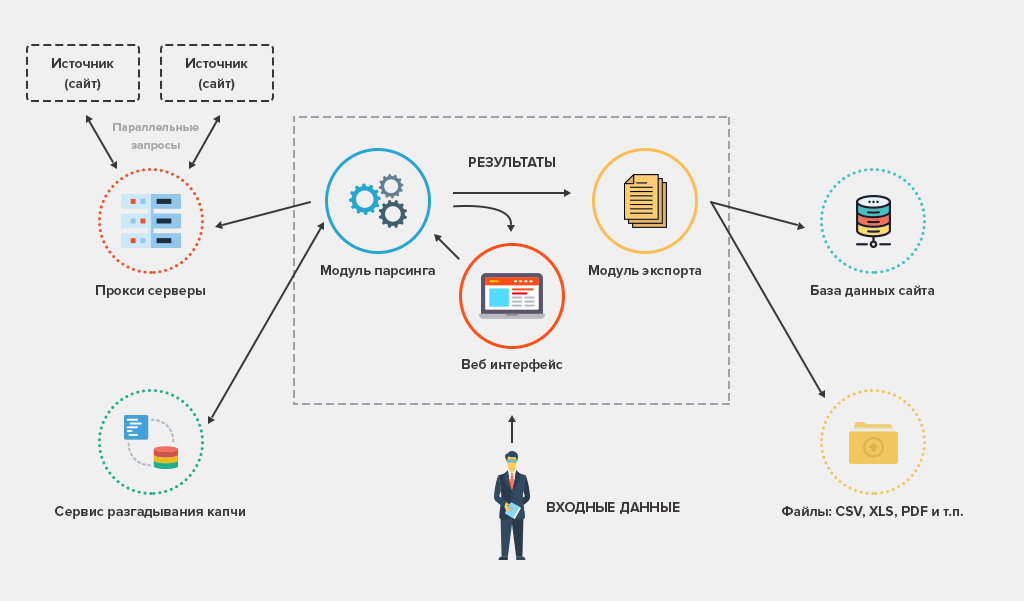

Помимо того, что шаблоны целевого сайта могут меняться, никто не хочет, чтобы их парсили. Дело даже не в том, что парсинг создает дополнительную нагрузку, а в том, что каждый дорожит своим контентом и не хочет им делиться. Видя, что их контент начинают разбирать, реализуют всевозможные защиты. Например, если начать парсить Яндекс.Маркет, то уже через 5-10 страниц «нарвешься» на капчу (защиту от роботов, а парсер – и есть робот). Такие защиты надо как-то обходить. Использовать разные IP адреса, но для этого нужно иметь огромную подсеть, или анонимные прокси, которые очень быстро попадают в черные списки. Либо интегрировать парсеры с сервисами автоматического распознавания капчи.

Нет ничего не возможного!

У нас работают настоящие хакеры сетевых протоколов, мы давно нашли решение парсить всё, в том числе и Яндекс.Маркет. Все уже давно просниффлено, даже защищенный протокол, на который давно перешли. В своих парсерах мы можем задавать запросы сотнями одновременно, не попадая ни под какие санкции.

Только Маркет? Нет, конечно!

С какими только задачами парсинга не обращались к нам клиенты. Например, брали данные у известных агрегаторов скидок по продуктовым и алкогольным предложениям. Для себя умеем сканировать выдачу поисковых систем для мониторинга позиций или анализа. Последнее, с чем работаем – это парсинг групп одной крупной социальной сети.

Вам необходимо заказать парсер сайта или иных данных? Обращайтесь. Для нас нет ничего невозможного! Мы предоставим как готовый парсер, так и любую разовую выгрузку в форматах XML, CSV, SQL или в любом другом по требованию.

Все наши парсеры имеют:

- удобный интерфейс;

- стабильный функционал;

- фоновую работу над заданиями;

- пакетную многопоточную загрузку;

- масштабируемость.

Каждый парсер можно интегрировать с большинством CMS: Bitrix, Joomla, Wordpress и любой другой, которая использует открытый формат хранения данных, например, СУБД MySQL. Если у Вас нет собственного сайта – воспользуйтесь нашей услугой по разработке сайтов. Мы используем собственную ELiTES CMS, которая не имеет никаких ограничений по конфигурации под задачи заказчика и расширяемая любыми необходимыми модулями.

Похожие статьи

-

Создание веб-сайта «под ключ»

Создание веб-сайта «под ключ»Разработка полноценного сайта состоит из нескольких этапов. Каждый из них достаточно трудоемкий, каждый очень важен для последующего успешного существования сайта. Специалисты Студии интернет-решений EliTES выполнят все этапы профессионально на самом высоком уровне.

-

Как выбрать, чтобы не ошибиться?

Как выбрать, чтобы не ошибиться?Кому доверить работу по созданию своего сайта, как выбрать верное решение и не прогадать?

-

Разработка сайта дешево или скупой платит дважды.

Разработка сайта дешево или скупой платит дважды.Мы занимаемся разработкой сайтов уже более 15 лет. И почти каждый раз, когда к нам обращается новый клиент, он задает один и тот же вопрос: "Почему разработка сайта у вас стоит дороже, чем, например, в компании N...?".